Explicabilité/interprétabilité des réseaux de neurones profonds dans le domaine biomédical

Encadrants : Daniel Racoceanu

Disponible : OUI

Spécialité : IMA

Nombre d'étudiants : 1

Description : L'ambiguïté du processus décisionnel est considérée comme le principal obstacle à l'application pratique des approches basées sur l'apprentissage profond malgré leur performance exceptionnelles.

L'interprétabilité pourrait améliorer la confiance en ses système d'apprentissage profond, il est donc particulièrement important de développer des approches explicable/ interprétable, cela facilitera l’intégration du l’apprentissage profond dans le domaine biomédical (les systèmes d’aide à la décision).

Pré-requis : Python, PyTorch, OpenCV, CUDA

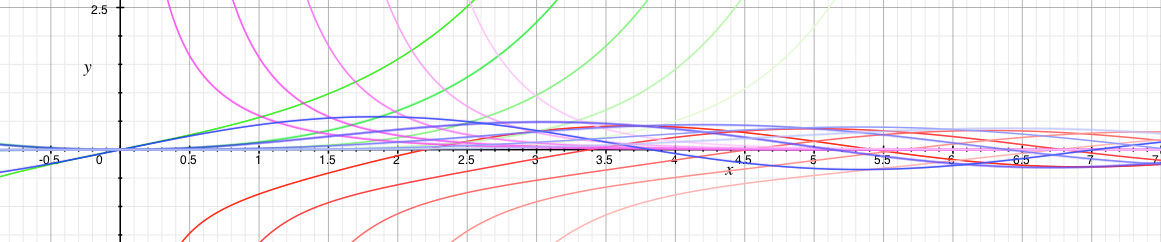

Travail demandé : Dans cette étude, Il est demandé dans un premier temps de faire un état de l'art des techniques d’explicabilités/interprétabilité appliqué aux réseaux à l’apprentissage profonds (XDL). Dans le second temps, il vous sera demander d'implémenter un algorithme d’explicabilité en concertation avec l'encadrant, par exemple : un générateur des justifications visuel (carte d’attention) et textuel.

Liens complémentaires : https://arxiv.org/pdf/1906.03922.pdf

Fichiers complémentaires : Barredo Arrieta et al. – 2020 – Explainable Artificial Intelligence (XAI) Concept